Vía libre para los robots asesinos: potencias como EEUU y Rusia vetan en la ONU la propuesta de limitar el uso de armas que no estén controladas por humanos

Vía libre para los robots asesinos: potencias como EEUU y Rusia vetan en la ONU la propuesta de limitar el uso de armas que no estén controladas por humanos

No hubo acuerdo. Por no haber, no hubo ni siquiera acuerdo en que no había acuerdo. La semana pasada, la Convención sobre Prohibiciones de Ciertas Armas (CCW, por sus siglas en inglés) se cerró tras 8 años de acalorados debates, largas discusiones y concienzudos estudios encargados a entidades de todo tipo.

No es cualquier comisión. Tras tan eufemístico nombre se esconde el esfuerzo de cerca de un centenar de países por regular lo que se conoce como Sistemas de Armas Autónomas Letales (LAWS, por sus siglas también en inglés). Otro eufemismo para hablar de armas autónomas.

Pueden ser drones, pero también, por ejemplo, misiles guiados por inteligencia artificial. Con los años, puede que hasta adquieran aspecto humanoide.

Comparten un requisito: en cuestión de segundos, guiadas por tecnologías como la inteligencia artificial y con escasa o nula supervisión humana, son capaces de definir un objetivo y acabar por él.

En otras palabras, son máquinas que deciden quién vive y quién muere.

Vertipuertos y taxis aéreos, la próxima revolución del transporte que encabeza Ferrovial en España

No son ciencia ficción. Tras décadas de desarrollo, gracias a tecnologías como la propia IA o los sistemas de reconocimiento de imagen, existen ya informes que atestiguan su uso en conflictos armados.

Por ejemplo, recuerda el New York Times, el pasado mes de marzo investigadores de la ONU afirmaron que fuerzas respaldadas por el gobierno en Libia habían utilizado contra las milicias un dron llamado Kargu-2.

Fabricado por un contratista de defensa turco, el dron rastreó y atacó a los combatientes cuando huían de un ataque con cohetes, según el informe, que no dejó claro si algún humano controlaba los mandos del aparato.

En la guerra de 2020 en Nagorno-Karabaj, recuerda también el rotativo, Azerbaiyán empleó contra el ejército armenio misiles que básicamente pasan un tiempo merodeando en el aire hasta que detectan la señal de un objetivo asignado y se dirigen a él.

Y la lista suma y sigue. Tanto es así que este año en la CCW, por primera vez, existía un amplio consenso para establecer un protocolo contra estas armas.

Pero esto no basta. Dado que cualquier decisión que salga de estos grupos de trabajo ha de ser fruto del pleno consenso, es decir, debe contar con el apoyo de absolutamente todos sus miembros, no es suficiente simplemente con que la mayoría desee un protocolo para que este salga adelante.

Ni siquiera es suficiente que la mayoría sea abrumadora: con que un solo país no esté de acuerdo, todo queda como al principio.

Es exactamente lo que ha sucedido. EEUU, Rusia, Israel, la India y Reino Unido, principalmente y cada uno por sus motivos, han rechazado siquiera empezar a negociar para poner coto a esta tecnología.

La conferencia concluyó con solo una vaga declaración sobre la consideración de posibles medidas aceptables para todos. Papel mojado.

Esta increíble mano robótica puede sostener un huevo sin romperlo, verter bebidas y estrujar latas de cerveza

A diferencia de lo que ha sucedido en otras reuniones de la CCW que, por ejemplo, han prohibido el uso de láseres cegadores o de minas antipersona, de este sexto encuentro no saldrá decisión firme alguna.

Esto, después de que 40 países, según relata Humans Right Watch, pidieran de un modo más o menos claro durante las negociaciones una nueva legislación internacional para prohibir y restringir los sistemas de armas autónomas.

@Barnacules you never said how to open regedit btw

— Benji - Po Wed Nov 23 10:53:09 +0000 2016

Entre ellos se encuentran Argelia, Argentina, Austria, Bolivia, Brasil, Chile, Colombia, Costa Rica, Croacia, Cuba, Ecuador, Egipto, El Salvador, España, Filipinas, Ghana, Guatemala, Irak, Jordania, Kazajistán, Malta, Marruecos, México, Namibia, Nicaragua, Nigeria, Nueva Zelanda, Palestina, Pakistán, Panamá, Perú, Santa Sede, Sierra Leona, Sri Lanka, Sudáfrica, Uganda, Venezuela, Yibuti y Zimbabue.

A ellos cabe añadir otros algo más ambiguos como China, que se mostró contraria solo a la aplicación de estas armas, o Portugal, que se limitó a pedir que los países recogieran usos contrarios a los derechos humanos de estas armas, un reclamo considerado insuficiente por la mayoría.

Estas peticiones se han topado con una buena cantidad de intereses. Para empezar, el New York Times señala a quienes define como "planificadores de la guerra".

Se trata de empresas que forman parte de la industria armamentística y que ofrecen la promesa de mantener a los soldados fuera de peligro gracias a sistemas autónomos como los drones: guerras de guante blanco.

Es por ello que el principal delegado estadounidense en la conferencia, Joshua Dorosin, lo más lejos que llegó fue a proponer un código de conducta no vinculante.

Glovo lanza sus primeros robots repartidores autónomos en Madrid y las redes sociales estallan con mensajes neoluditas: "Como me lo encuentre le doy una patada"

Detrás de esta propuesta, que fue calificada en el mejor de los casos como una estrategia para dilatar la puesta en marcha de un protocolo firme, se encuentran los intereses del ejército estadounidense.

Este trabaja con empresas como Lockheed Martin, Boeing, Raytheon y Northrop Grumman en proyectos que incluyen el desarrollo de misiles de largo alcance que detectan objetivos en movimiento, drones enjambre que pueden identificar y atacar un objetivo y sistemas automatizados de defensa de misiles.

Son viejos conocidos del ejército. La primera, relata la periodista Naomi Klein en su libro La doctrina del shock, ya en los años 90 se encargaba de los departamentos de tecnología de la información del ejército de EEUU, y Northrop es el fabricante del famoso bombardero B-2 Spirit, capaz de penetrar defensas antiaéreas.

Objetivo: frenar a los robots asesinos

La cuestión incluso ha llegado a Silicon Valley. En verano de 2018, Google tuvo que dar marcha atrás a lo que se conoció entonces como Proyecto Maven, un acuerdo de la empresa con el Pentágono en virtud del cual el ejército estadounidense podría valerse de la IA desarrollada por el gigante tecnológico para armas militares.

El escándalo público y el malestar entre los empleados obligó entonces a la empresa a redactar un código ético que clarificara los posibles usos de su IA y apartara de la compañía la sombra de la guerra.

Entre la gente quedó, sin embargo, la idea de que hay países dispuestos a asociarse con cuanta empresa haga falta para desarrollar su tecnología para matar.

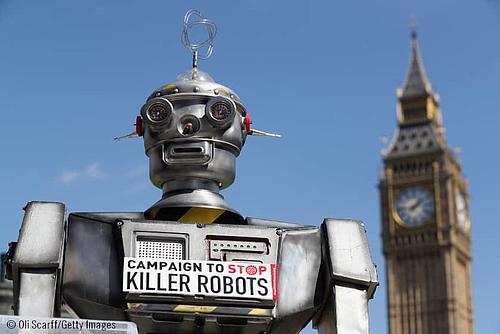

Se trata exactamente de la clase de temores que llevaron en 2013 al nacimiento de Stop Killer Robots, una organización que hizo llegar a la convención a través del embajador francés Yann Hwang 17.000 firmas pidiendo límites a las armas automáticas.

Por un lado, Stop Killer Robots entiende como algo moralmente rechazable el asignar la toma de decisiones letales a máquinas, independientemente de su sofisticación tecnológica.

Por otra parte, tienen dudas sobre su eficacia. ¿De verdad pueden diferenciar en todos los casos y con ningún margen de error a un combatiente de un niño, a alguien que lleva un arma de alguien que no la lleva?

Y aún más allá: ¿pueden las máquinas distinguir en todos los casos un combatiente hostil de alguien que se quiere rendir?

"Los sistemas de armas autónomas plantean a la sociedad la preocupación ética de sustituir las decisiones humanas sobre la vida y la muerte por procesos de sensores, programas informáticos y máquinas", declaró en la conferencia Peter Maurer, presidente del Comité Internacional de la Cruz Roja y abierto opositor a los robots asesinos.

Antes, Human Rights Watch y la Universidad de Harvard ya habían abordado la cuestión en un informe de 23 páginas cuyas conclusiones fueron claras.

Mercedes se adelanta a Tesla al obtener la homologación del nivel 3 de conducción autónoma en Alemania: esto es lo que significa

"Los robots carecen de la compasión, la empatía, la misericordia y el juicio necesarios para tratar a los seres humanos con humanidad, y no pueden entender el valor inherente de la vida humana", argumentaron los grupos en un documento informativo para apoyar sus recomendaciones.

“La ausencia de un resultado sustantivo en la conferencia de revisión de la ONU es una respuesta totalmente inadecuada a las preocupaciones planteadas por los robots asesinos”, dijo Steve Goose, director de la división de Armas de Human Rights Watch.

Ahora, la pelota queda de nuevo en el tejado de los países. Entre los defensores del desarme empieza a cundir la sensación de que estas comisiones no son un instrumento válido para legislar algo tan grave como las armas autónomas.

Entre quienes sostienen esto se encuentra por ejemplo Daan Kayser, experto en armas autónomas de PAX, un grupo de defensa de la paz con sede en los Países Bajos: "El hecho de que la conferencia no se pusiera de acuerdo ni siquiera para negociar sobre los robots asesinos es una señal realmente clara de que la CCW no está a la altura", ha comentado al New York Times.

Noel Sharkey, experto en inteligencia artificial y presidente del Comité Internacional para el Control de Armas de Robots, se ha mostrado todavía más tajante. A su modo de ver, es preferible negociar directamente un nuevo tratado que esperar a más deliberaciones de la CCW.